Quel rôle doit jouer le designer dans la conception d’un système d’assistance ?

Je rejoins Adam Greenfield dans l’idée qu’ “ à moins d’un effondrement global de notre civilisation technologique, [...] le développement d’une forme d’ubimedia est inévitable, au moins dans les pays développés ”, en particulier du fait de notre modèle de croissance économique de plus en plus basé sur les services, encouragé par le vieillissement de la population ou encore par “ nos besoins de plus en plus forts en sécurité et en surveillance ”. Comme lui je crois que l’immense majorité des futurs utilisateurs de ces technologies ne connaîtront rien à leurs logiques intrinsèques de fonctionnement et accepteront par “ commodité ” de se laisser guider par leurs interfaces simplifiées sans nécessairement chercher à les comprendre, dans une sorte d'ignorance consentie. Nous sommes au point de bascule du développement de ces technologies d’assistance, qui commence déjà à se répandre massivement mais qui n’ont pas encore remportées une adhésion unanimes comme les smartphones ou les plateformes de streaming vidéo. Leurs méthodes de conception et le rôle de leurs concepteurs peuvent et doivent donc être questionnés. Il est grand temps de définir les règles et standards de développement de ces technologies, car comme le pressent Greenfield, “ nous devrions faire ça avant que nos vies ne soient submergées d’interfaces “ mal fichues ”, d’implémentations illogiques et d’entrave à nos libertés ”. Ce travail sera complexe, alors que l’accès facilité par les constructeurs aux langages et interfaces de programmation des services pour assistant a “ démystifié le processus de développement ”, tout en permettant aujourd’hui une “ augmentation drastique, sans précédent, du nombre de non spécialiste impliqués dans le développement d’applications “ faites maisons ” ”, ce que l’essor des projets d'entreprenariat dans le domaine des services a démontré. Les concepteurs de systèmes d’assistance ont pourtant la responsabilité morale de garantir par leurs choix la protection de leurs futurs utilisateurs, notamment comme le préconisait Mark Weiser dans son texte “ en les construisant de la façon la plus sécurisée possible ” et en y “ incorporant tous les garde-fous imaginables pour protéger les valeurs individuelles ”.

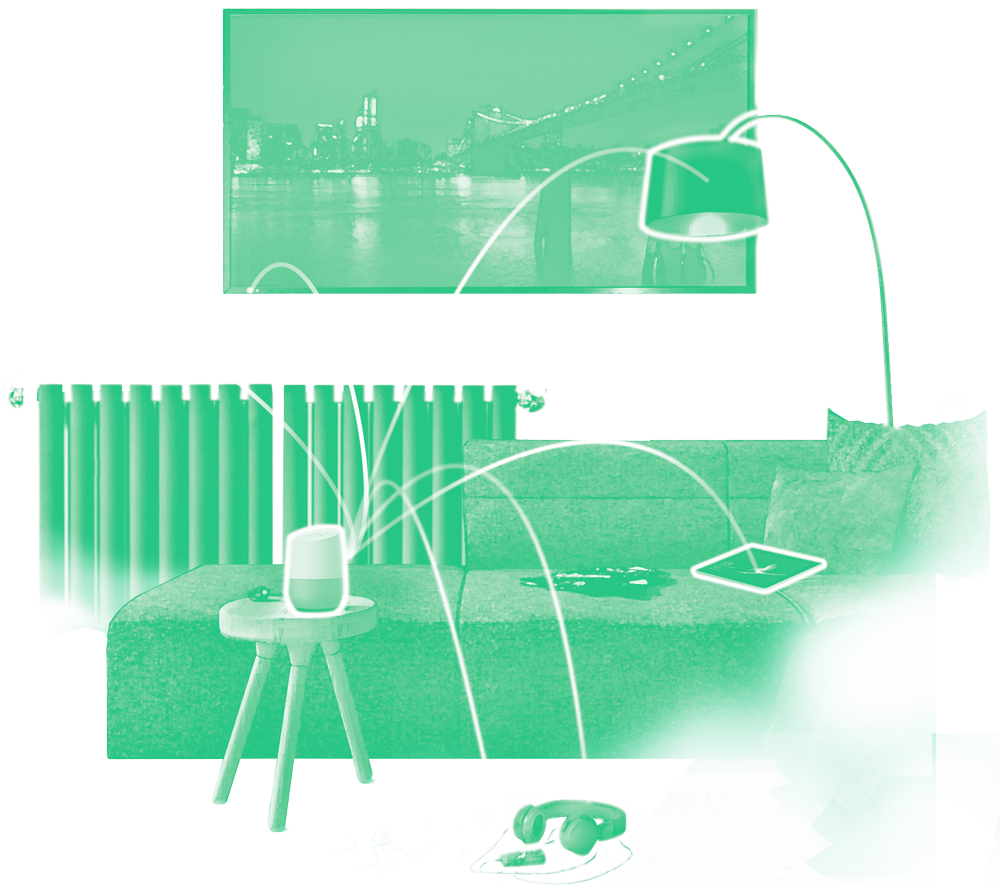

Alors qu’une grande partie des développements de ces systèmes et services semblent se faire sans que ces questions ne soient abordées, les designers me semble pouvoir jouer un rôle intéressant dans ce travail. Il est aujourd’hui frappant de voir comment certains designers intégrés dans des grands groupes comme Google se retrouvent souvent à jouer le rôle d’ambassadeur voire de support promotionnel des produits qu’ils conçoivent, en se mettant en scène les utilisant dans un cadre privé. Lors de la conférence évoquée plus tôt, Anthony Masure s'interrogeait d’ailleurs : “ Le design a-t-il pour vocation d’accompagner sans heurts le développement du capitalisme cognitif ? ”, concluant par le fait que le rôle du designer ne devrait pas être de produire de l’acceptation sociale de ces technologies par des procédés de conception malhonnêtes, en permettant la mise en place concrète d’usages malsains basés sur une hyper-stimulation de l’utilisateur et une hyper-exposition à des contenus commerciaux. Pour un designer critique, un arbitrage complexe est à faire au cas par cas entre le fait de participer au développement probablement inévitable de ces technologies et le fait de concevoir des usages qu’il estime non éthiques et non respectueux des libertés des utilisateurs. En d’autres termes, le designer peut-il aider à remettre en cause un système tout en y participant ? À part dans des entreprises aux enjeux commerciaux aussi énormes que Google ou Amazon, je crois que l’exercice est possible, et même nécessaire, car une posture de rejet technophobe ne touchera pas ou peu les utilisateurs des futurs systèmes qui émergeront malgré tout, et aboutira donc selon moi à des dérives bien plus malsaines que ne le fera une pratique critique de la discipline. Les designers peuvent apporter à ces projets leurs méthodes de conception centrées avant tout sur les usages et les utilisateurs, découlant ensuite sur des besoins technologiques pertinents, au lieu de partir comme c’est trop souvent le cas d’une innovation technologique pour imaginer peu pertinemment de nouveaux besoins. Ils peuvent jouer en interne des processus de conception un rôle de garde fou, afin d’accompagner les constructeurs des ces technologies vers une prise de position plus claire quant à leurs choix formels en terme d’expérience utilisateur, d’interface vocale ou encore de design de conversation.

Triona Butler, designer UX chez Google, Colm Mahady / Fennell Photography, 2018

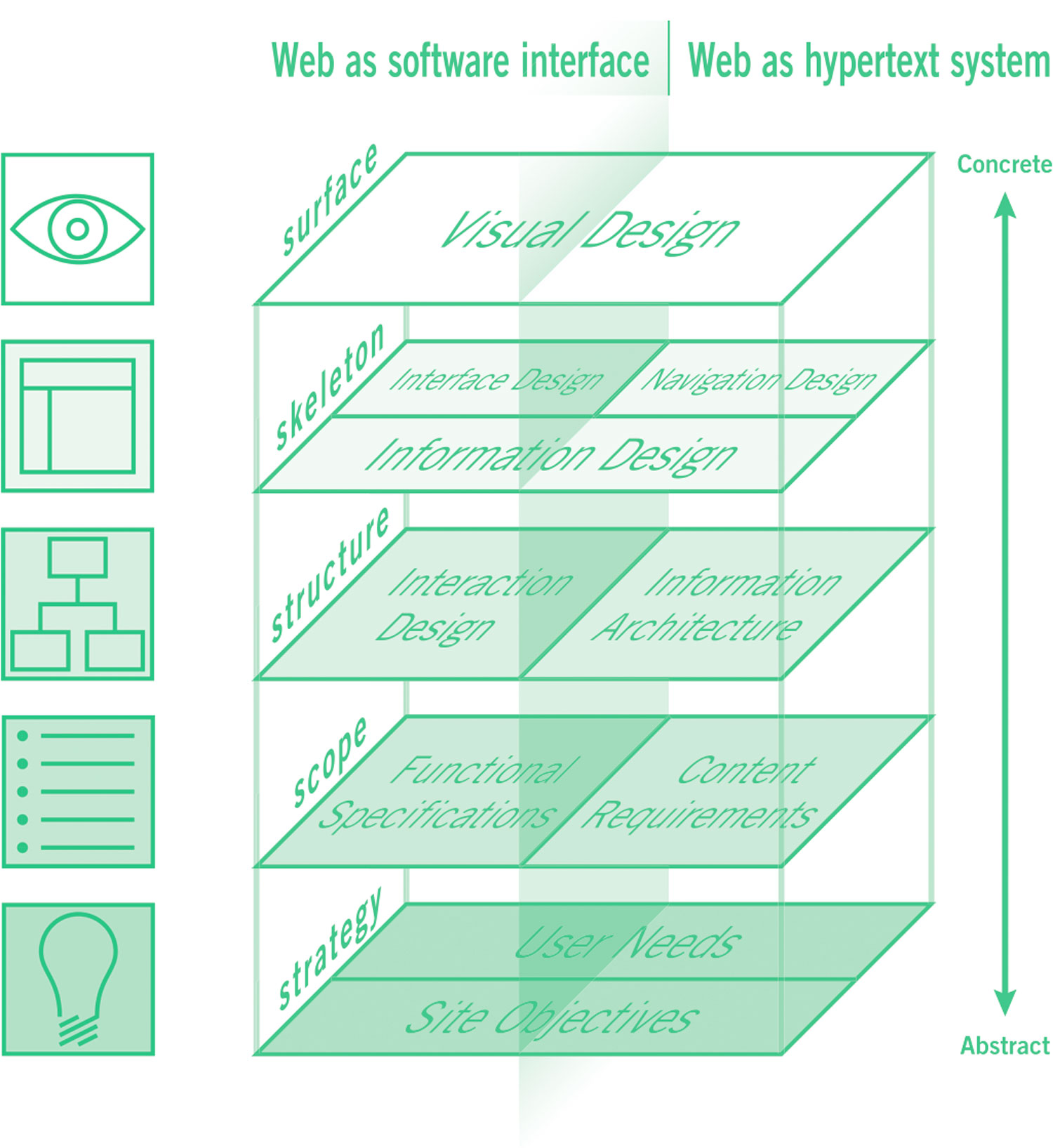

Mais comment les designers peuvent ils intervenir plus concrètement sur la conception de ces produits, tout en prenant en compte les intérêts des constructeurs et ceux des utilisateurs ? Dans son cahier sur la “ forme des choix ” dans le design de produits numériques, évoqué plus haut, la CNIL expliquait que “ le design des interfaces n’a pas attendu le

Règlement général sur la protection des données (RGPD) pour influencer nos vies ”, en affectant intentionnellement ou non la façon dont les utilisateurs interagissent avec les systèmes technologiques. Cependant, ce règlement “ introduit dans son article 25 la notion de “ privacy by design and by default ”, traduite en français par “ protection des données dès la conception […] et par défaut ” ”, qui force les concepteurs de produit ou service à garantir par défaut à leur utilisateur le plus haut niveau possible de protection de leurs données et intérêts personnels, notamment en encourageant “ la participation active des personnes concernées dans la protection de leur vie privée en leur demandant d’activer intentionnellement des fonctionnalités invasives ”. Dans cette idée, le rôle concret des designers serait alors “ d’identifier, dans les outils et services numériques, les endroits clés où ces dynamiques d’influence se concentrent ”, afin de garantir une expérience d’utilisation non biaisée et transparente pour l’utilisateur. Ce travail repose sur la reconnaissance d’un ensemble de “ pratiques de design potentiellement trompeur ”, ayant pour but de pousser l'individu à accepter de partager plus que ce qui est strictement nécessaire, d’Influencer son consentement, de créer de la friction aux actions de protection des données ou simplement de dérouter l'individu, pratiques à proscrire pour obtenir à chaque étape de l’utilisation du produit le consentement libre et éclairé de l’utilisateur. Adam Greenfield estime à juste titre que “ même si l’on pouvait compter sur les développeurs pour agir de bonne foi, cela ne serait pas assez précis pour constituer un guide d’une quelconque utilité pratique ”, et il propose donc au terme de sa réflexion un ensemble de 5 règles applicables par les concepteurs de systèmes d’ubimedia, définissant de façon détaillée les objectifs que ces derniers doivent selon lui se fixer en prenant en compte leurs potentielles dérives. Cet ensemble de règles transposable au design des systèmes d’assistance me semble très intéressant à commenter et à utiliser comme base de réflexions pour établir les bonnes pratiques de conceptions de ces technologies. C’est ce que je propose de faire maintenant en conclusion de cette dernière partie.

1. Les dysfonctionnements de l’ubimedia ne doivent pas entraîner de danger

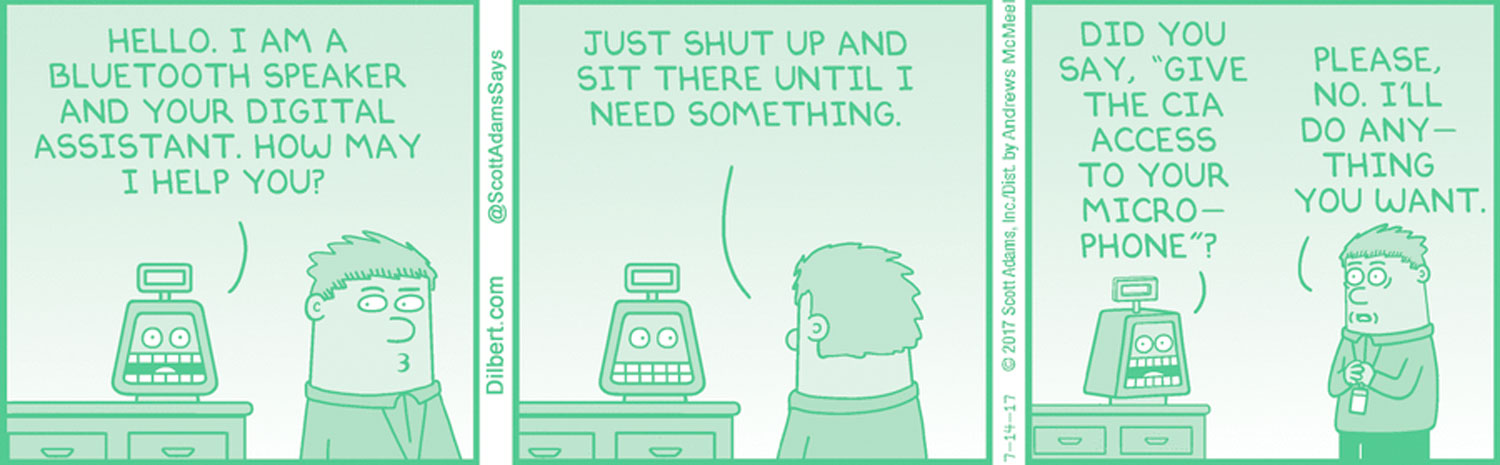

Selon cette règle, les assistants devraient en toute circonstance fonctionner “ de sorte qu’ils garantissent la sécurité de l’utilisateur, d’un point de vue physique, psychique et financier ”, en fonction de la perception culturelle de ces notions selon la nationalité de l'utilisateur. Ils devraient notamment être conçu selon un principe de “ dégradation élégante ”, qui garantit “ qu’en cas de dysfonctionnement le système doit cesser de fonctionner de façon douce, non de façon catastrophique, et ses fonctionnalités doivent s’arrêter progressivement ”, en particulier en rendant les causes de ces dysfonctionnements compréhensibles pour l’utilisateur. Cette règle paraît évidente, mais elle est pourtant relativement complexe dans son application concrète, du fait de la courbe exponentielle du développement de ces technologies. Je crois que des brèches de sécurité pourront toujours émerger ou des personnes mal intentionnées nuire aux utilisateurs, peut-être pas physiquement, mais moralement et financièrement, en récupérant des données à leur insu pour les revendre, ou en piratant micros ou caméras pour soutirer de l’argent par chantage, de manière similaire à une

pratique récente. Les concepteurs se doivent donc d’envisager et de tester toutes ces failles avant de diffuser leurs systèmes. Ils peuvent aussi accompagner les législateurs, les états et les autorités de contrôle, dans l’étude de la dangerosité potentielle de certains produits. La CNIL, qui intègre des designers à ses équipes, milite justement pour que les autorités de protection des données européennes “ recrutent davantage de compétences nécessaires à l’analyse des interfaces, en faisant appel de manière ponctuelle ou plus régulière à des équipes de designers et de spécialistes des questions de psychologie des individus ”, notamment en constituant des laboratoires transversaux. Ce type de démarches pourraient permettre aux designers de tirer partie de leur expertise de conception pour questionner au cas par cas les nouveaux usages de ces systèmes et garantir le respect des règles posées par les législateurs pour garantir l’intégrité des utilisateurs de ces systèmes.

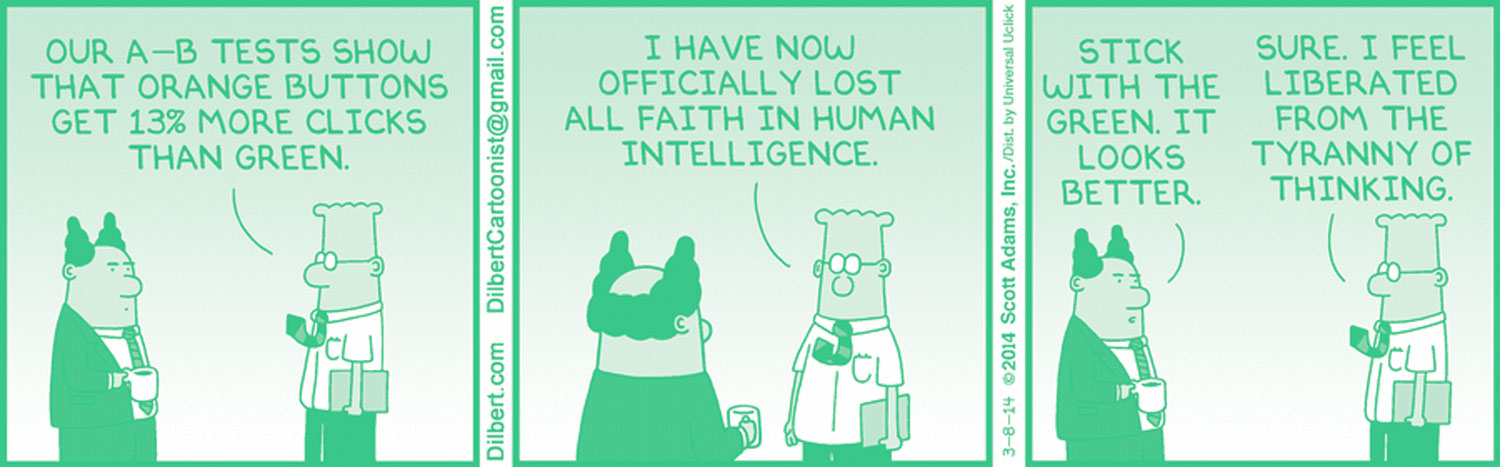

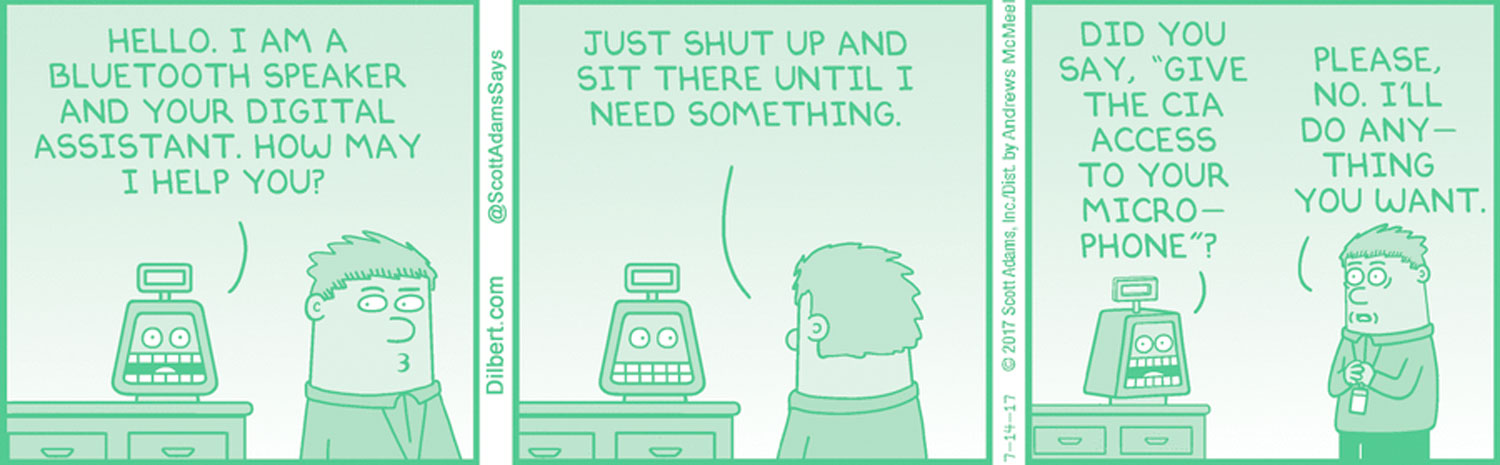

Dilbert, Scott Adams, 2017

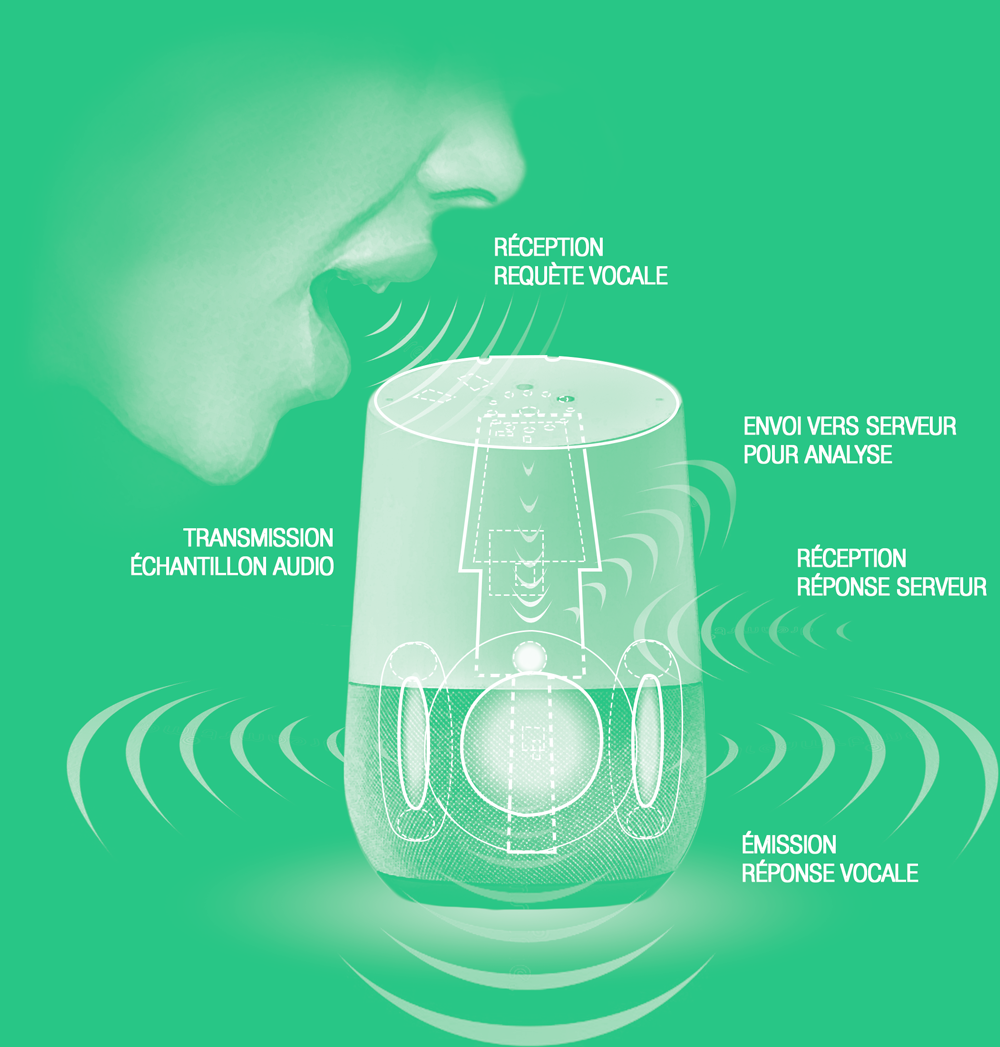

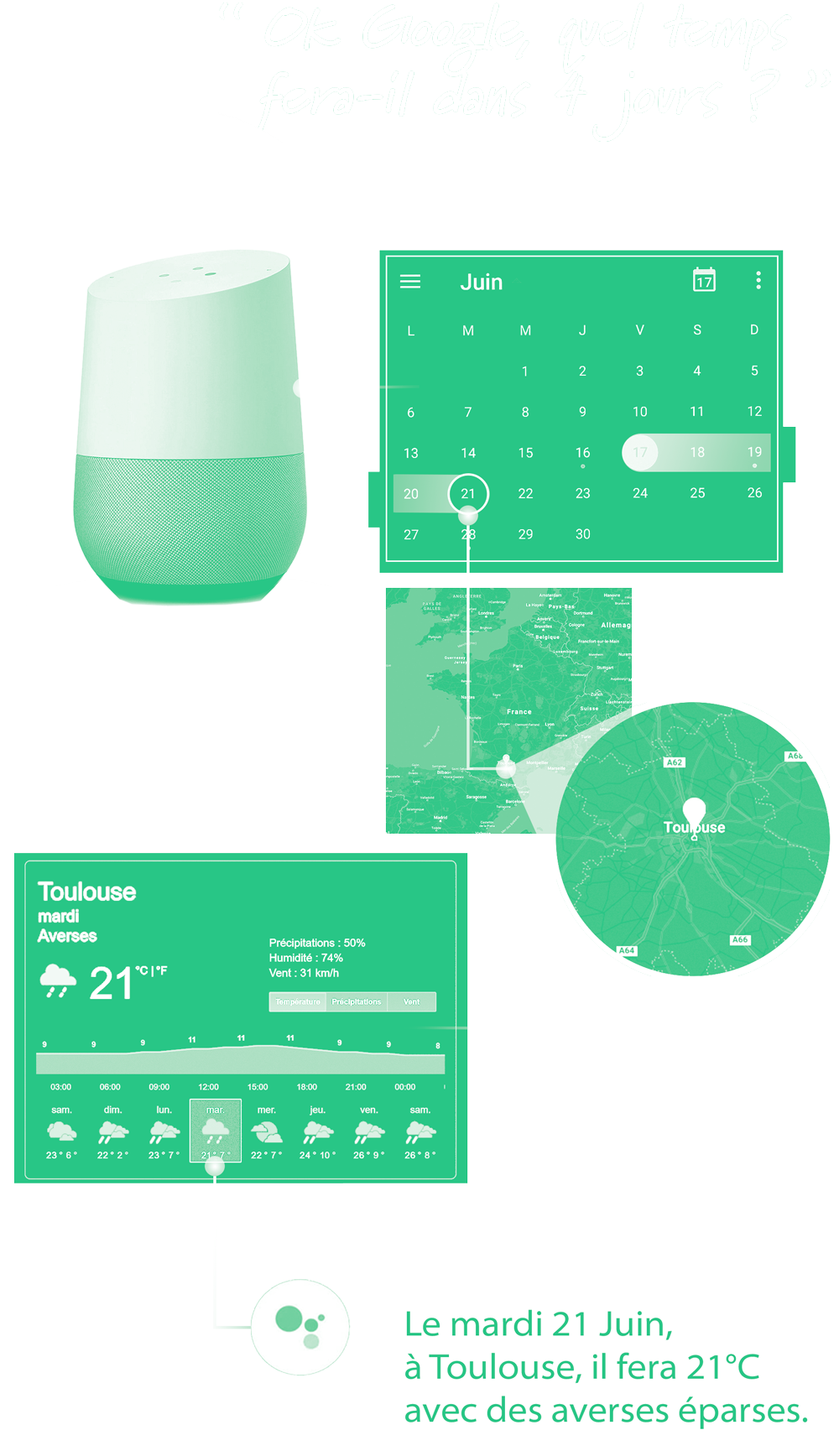

2. L’ubimedia doit s’autoprésenter

Selon cette règle, les assistants devraient avoir l’obligation de nous informer de leur présence dans un objet ou un environnement, qu’il soit matériel (enceinte, objet “ connecté ”…) ou immatériel (site web, système d’exploitation…). Le concepteur du système devrait permettre à l’utilisateur de “ savoir quel type de collecte d’information est mis en oeuvre dans un endroit donné, de quel genre d’informations il s’agit, qui en est responsable, et dans quel but cela s’effectue ”, mais aussi l’informer sur “ la façon dont les systèmes sont connectés à d’autres ”, en fournissant “ les moyens - de façon immédiate et transparente - de connaître leurs propriétaires, leur utilisation et leurs possibilités ”. Cette réflexion amène à celle sur les “ coutures ” de ces systèmes, terme énoncé par Mark Weiser désignant leur fonctionnement interne et leurs connexions avec d’autres systèmes. Deux approches de conception s’opposent : le “ sans couture ” (seamless), selon lequel ces éléments doivent être rendus imperceptibles pour l'utilisateur, et le “ avec couture ” (seamfull), selon lequel ils doivent à l’inverse être rendus perceptibles et intelligibles. Ces deux approches sont depuis longtemps débattues dans la communauté de l’informatique ambiante, débat depuis généralisé à la conception de tous les systèmes technologiques. Si Weiser voyait le “ sans couture ” comme une approche indésirable, car “ fondamentalement facteur d’homogénéisation ”, Adam Greenfield constate que ces idées “ ont été étrangement inversées au fur et à mesure qu’elles devenaient réalité ”, étant souvent “ présentées comme assurément bonnes ” dans une sorte de “ paternalisme ” qui “ prive l’utilisateur d’une participation active aux décisions qui affectent l’expérience qu’il vit ”. Je rejoins sur ce point Mark Weiser qui plaidait donc au contraire pour une conception de systèmes avec “ plein de couture, avec de belles coutures ”, afin d’aider les utilisateurs de manière didactique à “ comprendre les systèmes qu’ils rencontrent, comment ils fonctionnent et ce qui se passe aux jonctions entre plusieurs systèmes ”.

Comme on l’a vu, les systèmes d’assistance tendent souvent à invisibiliser leurs logiques de fonctionnement et notamment la gestion qu’ils font des données d’utilisation et leur communication avec les bases de données des fournisseurs de services proposés au travers de l’assistant car, comme l’analysait la CNIL dans son cahier, “ la simplicité se voit aujourd’hui mise au service du principe d’efficacité, paradigme dominant de notre société, afin que l’utilisateur ne perde pas de temps et exécute rapidement ce qu’il souhaite ”. Cette pensée et ces principes sont de fait “ souvent considérés comme indiscutables et imprègnent les bonnes pratiques des professionnels ”, popularisée par des ouvrages comme

Don’t make me think du consultant en expérience utilisateur Steve Krug, dans lequel l’auteur affirme à propos de l’utilisation d’un produit que “ je devrais être capable de comprendre ce que c’est et comment l’utiliser sans aucun effort pour y penser ”. L’ouvrage “

De la simplicité ” de John Maeda, designer numérique et essayiste influent, fait aussi référence dans le design d’interface, d’expérience utilisateur et d’objets technologiques, mais me semble essentiel à re-questionner au vu des enjeux de design contemporains. L’auteur y proposait, en 2006, 10 lois de conception ayant pour but de réduire autant que possible l’effort et le temps d’usage d’un produit, en atténuant sa complexité, masquant les parties les moins utilisées de l’objet et réduisant le panel de commandes proposées. Si ces principes servaient à la sortie du livre à repenser les interfaces très compliquées qu’on trouvaient alors, les designers contemporains se doivent de remettre en question certains d’entre eux, en particulier pour des objets comme les assistants, car l’extrapolation de ces “ lois ” contribue aujourd’hui à déconnecter les utilisateurs du fonctionnement réel des objets qu’ils utilisent et à dissimuler l’emploi de techniques commerciales agressives en lien avec ces objets, que le livre n’évoque que très peu. Les designers doivent selon moi refuser de masquer des caractéristiques intrinsèques du produit, que ce soit à travers d’interfaces “ naturelles ” invisibilisant “ par défaut ” les comportements du système ou l’origine réelle des contenus proposés, ou par un design trompeur, comme l’a par exemple fait Google en dévoilant lors d’une mise à jour que son système d'alarme

Nest Secure intégrait un microphone

jusqu’alors inactif, non mentionné dans la fiche technique de l’objet. À l’inverse, je crois que le designer de système d’assistance se doit d’indiquer de manière affordante à l’utilisateur les interactions possibles avec le système et ses potentialités d’interaction avec d’autres objets, mais aussi, comme le suggérait pertinemment Maëda dans sa loi sur la “ différence ” entre simplicité et complexité, de “ proposer par vagues des accès à la complexité du système ”, dans certains cas d’usage. Car comme le rappelle Adam Greenfield, “ même si l’effort conduisant à masquer des éléments du système à l’utilisateur est bien intentionné, il devrait toujours demeurer possible, pour ceux qui le souhaitent de faire apparaître au grand jour l’entière complexité du système. ”

Schéma illustrant “ De la simplicité ”, John Maeda, 2006

3. L’ubimedia ne doit pas faire perdre la face

Selon cette règle, les assistants devraient “ dans un fonctionnement normal, éviter de placer les utilisateurs dans une situation embarrassante ou humiliante, et leur épargner le ridicule ou l’opprobre public ”. Les concepteurs de ces systèmes doivent en particulier s’assurer que les procédés de déduction des comportements et des préférences des utilisateurs n’impactent pas en mal leur relation aux autres ou à eux mêmes, notamment en permettant “ qu’il soit toujours possible, quand on le souhaite, d'empêcher quelqu’un (ou quelque chose) de tirer des conclusions sur nos intentions ou nos agissements ”. Principe qui peut s’avérer complexe à respecter lorsque plusieurs utilisateurs ont l’usage d’une même enceinte et peuvent donc tous avoir accès à l’historique de leurs conversations mutuelles avec l’assistant... Problème renforcé par les nombreux dysfonctionnements des assistants, comme en témoigne l’exemple de Kashmir Hill, qui peu de temps après s’être fait filmer nue à son insu par sa caméra raconte avoir eu une dispute avec son mari quand celui-ci débrancha une des caméras pendant qu’elle était en voyage sans la prévenir à l’avance. Le designer participant à la conception d’un assistant a la responsabilité d'anticiper comment tous les différents usages possibles de celui-ci peuvent impacter en mal la vie personnelle, sociale, familiale voire professionnelle de ses utilisateurs. Dans l’excellente vidéo “

Our Friends Electric ” réalisée pour le

Mozilla’s Open IoT Studio, le studio de design Superflux imaginait 3 assistants et 3 enceintes fictionnels, présentant des types d’interactions non souhaitables mais proches de certains usages existants. Deux en particulier me semblent intéressants à mentionner ici, qui questionnent avec finesse le rôle actuel de ces technologies et leurs logiques de fonctionnement. Le premier, Eddi, est un assistant qui pose beaucoup de questions à son utilisateur avant de répondre à chaque requête, afin de comprendre à son insu ses motivations dans le but de déduire ses habitudes de vie et finir par prendre peu à peu le pas sur l’autonomie de ce dernier. Le second pressentait finement l’apparition de services comme Google Duplex, en imaginant un assistant capable de passer un appel à la place de son utilisateur, tout en permettant à ce dernier de moduler différents traits de caractère de l’assistant, par exemple en diminuant sa politesse ou en augmentant sa confiance en lui. En nous montrant une utilisatrice s’en servir pour faire réclamation auprès de son fournisseur d’énergie et faisant devenir l’assistant de plus en plus agressif au fil de l’appel, la vidéo illustre le risque que ces technologies soient utilisées pour déléguer la responsabilité et l’impact émotionnel de certaines de nos interactions sociales, rappelant la tendance des “ haters ”, des internautes très virulents envers une personne ou une communauté sous couvert d’anonymat. Afin d’éviter ces dérives d’usage, le rôle des concepteurs de systèmes d’assistance sera selon moi au contraire de favoriser l’implication de leurs utilisateurs dans les relations qu’ils établiront à travers elles avec d’autres, afin de ne pas générer de gêne, de honte, d’incompréhension ou de conflit du fait de ces technologies.

Capture de “ Our Friends Electric ”, Superflux, 2017

4. L’ubimedia ne doit pas faire perdre de temps

Selon cette règle, les assistants ne devraient pas “ ajouter de complication superflue aux opérations ordinaires ”. S’ils proposent de remplacer “ l’improbable désordre ” des interactions que nous avons avec des infrastructures physiques et informationnelles et même parfois des objets que nous utilisons dans ces interactions (ordinateur, smartphone, enceintes, cartes de crédit, cartes d’abonnement ou de fidélité…), ce remplacement ne doit avoir lieu que s’il permet réellement de nous faire “ consommer moins de temps, d’énergie et d’attention ”. Comme le rappelle l’auteur dans un autre chapitre, ces systèmes n’auront pas que pour but de perfectionner des technologies existantes, mais elles s'insinueront aussi “ dans des transactions desquelles la technique était jusqu’alors absente ”, pouvant donc entraîner des formes de complexité d’usage et des situations d’échec qui n’existent pas actuellement. Les designers de systèmes d’assistance se doivent selon moi de résister à la volonté des constructeurs de se rendre indispensables, en identifiant et rejetant l’utilisation de techniques de design malveillantes ayant pour but de rendre fastidieux et complexe le réglage des paramètres de l’assistant en termes de préférences d’usage et de protection des données personnelles, ou de complexifier l’accès à ces réglages par un processus volontairement chronophage. Plus globalement, les designers ne doivent pas encourager l’hyper-stimulation de l’utilisateur par l’assistant, car comme s'interrogeait Hubert Guillaud dans son article : “ Nos meubles et gadgets ne finiront-ils pas par nous épuiser à force de devoir leur parler ? La commande vocale et son corollaire, l’écoute, nécessitent une attention bien plus captive encore que nos écrans dont nous ne cessons pourtant de nous plaindre ”. Pour ne pas participer à la prolifération incontrôlée des technologies d’assistance, leur développement et leur intégration dans notre environnement ne doit se faire qu’à partir de constats d’usage, de réelles situations inconfortables ou de manques, en évaluant à l’inverse les situations dans lesquelles ces systèmes ne sont pas pertinents, en particulier dans un cadre très intime. Ce travail doit selon moi passer par le refus des concepteurs d’intervenir dans des situations qui fonctionnent déjà bien actuellement afin, comme le dit pertinemment Adam Greenfield, “ que nos choix et nos moments les plus intimes ne soient pas envahis et demeurent libres. ”

Illustration pour le Wall Street Journal, Peter Arkle, 2018

5. Les systèmes ubiquistes doivent laisser la possibilité aux utilisateurs de s’en désengager, à tout moment et n’importe où

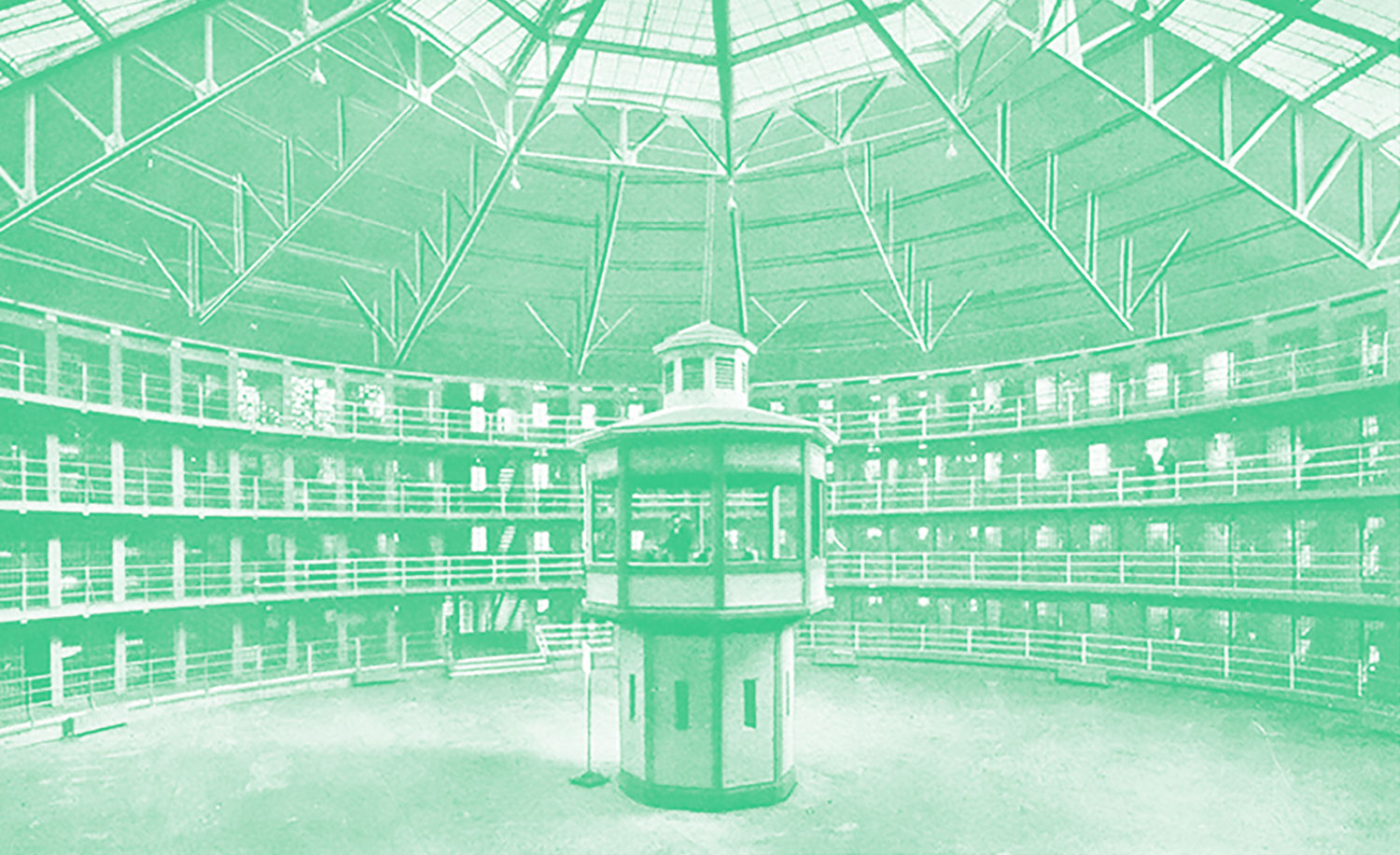

Selon cette règle, les assistants devraient pouvoir être éteint à tout moment “ sans [que l’utilisateur ne soit] pénalisé pour cela (autrement qu’en se passant des bénéfices éventuels qu’ils apportent) ”. Ces systèmes ne devraient jamais être exclusifs, et toujours permettre une alternative réaliste pour se passer d’eux ou les éviter sans conséquences. En tant qu’utilisateurs potentiels, nous devons pour cela disposer “ du pouvoir d’évaluer nous-mêmes leur mérite, et de prendre nos décisions en conséquence ”, en choisissant librement de les utiliser ou pas. Si actuellement ce problème ne se pose pas réellement avec les enceintes, que les utilisateurs achètent de leur plein gré, il est plus présent dans les cas où des assistants se retrouvent installés “ par défaut ” sur certains appareils, comme l’est Google Assistant sur les smartphones fonctionnant avec le système Androïd, sans que l’utilisateur n’ait la possibilité de le désinstaller. Dans ce type d’implémentation, le design de l’expérience utilisateur doit permettre de désactiver les fonctions d’assistance et de réaliser celles-ci manuellement. Les concepteurs du système ne doivent pas non plus selon moi pousser “ par défaut ” l'utilisateur à partager avec le système plus que ce qui est strictement nécessaire à son bon fonctionnement. Dans cette optique, les assistants doivent être conçus pour accompagner leurs utilisateurs dans le paramétrage de leurs fonctionnement, en particulier lors de l’initialisation du système, sans chercher à influencer le consentement de l'utilisateur pressé ou impatient de terminer cette étape souvent fastidieuse. Ce travail passe aussi par le fait d’énoncer clairement à l’utilisateur ce qui relève de fonctions nécessaires au fonctionnement ou à la sécurité du service et ce qui ne concerne que des fonctions additionnelles ou commerciales. Plus généralement, la “ désactivation ” temporaire des systèmes d’assistance me semblent être une sorte d’impasse, auquel leurs concepteurs ne peuvent rien, car en installant dans son cadre intime des objets intégrant micros et caméras, l’utilisateur ne peut jamais être sûr à 100% que ces derniers sont bien déconnectés quand il le souhaite… Car comme l’explique Kashmir Hill, “ avoir une maison intelligente signifie que tous ceux qui y vivent ou y entrent font partie de votre panoptique personnel ”, faisant référence à un type d'architecture carcérale conçue par le philosophe Jeremy Bentham, reposant sur une tour centrale depuis laquelle de fines ouvertures permettent à un gardien d'observer tous les prisonniers, enfermés dans des cellules individuelles autour de la tour, sans que ceux-ci puissent savoir s'ils sont observés ou non, afin de leur donner le sentiment d'être surveillés constamment. Une fois l’enceinte installée dans l’habitat et connectée à Internet, il n’est jamais certain que l’assistant ne soit pas en train de communiquer avec ses serveurs ou de nous enregistrer à notre insu, alors que Surya Mattu expliquait que l'Amazon Echo échange avec ses serveurs très régulièrement, même sans que la formule d’activation n’ait été prononcée ou lorsque le microphone était désactivé. À moins bien sûr de refuser d’utiliser ces objets tant qu’il ne permettront pas un usage hors connexion, même moins transverse et performant, quand l'utilisateur le souhaite.

Architecture panoptique de la prison de Stateville (Illinois), anonyme, 1925