Pouvons nous en tant qu’utilisateurs établir un contrat de confiance avec ces médias ?

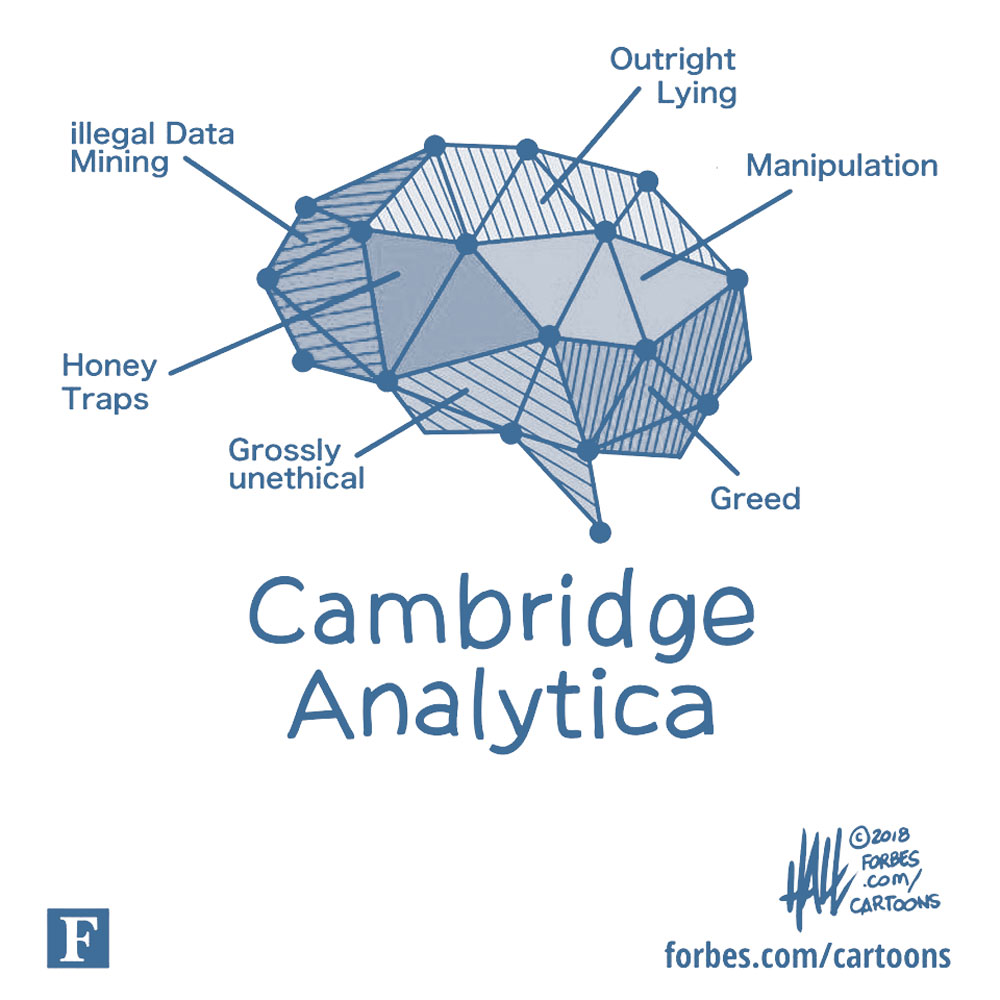

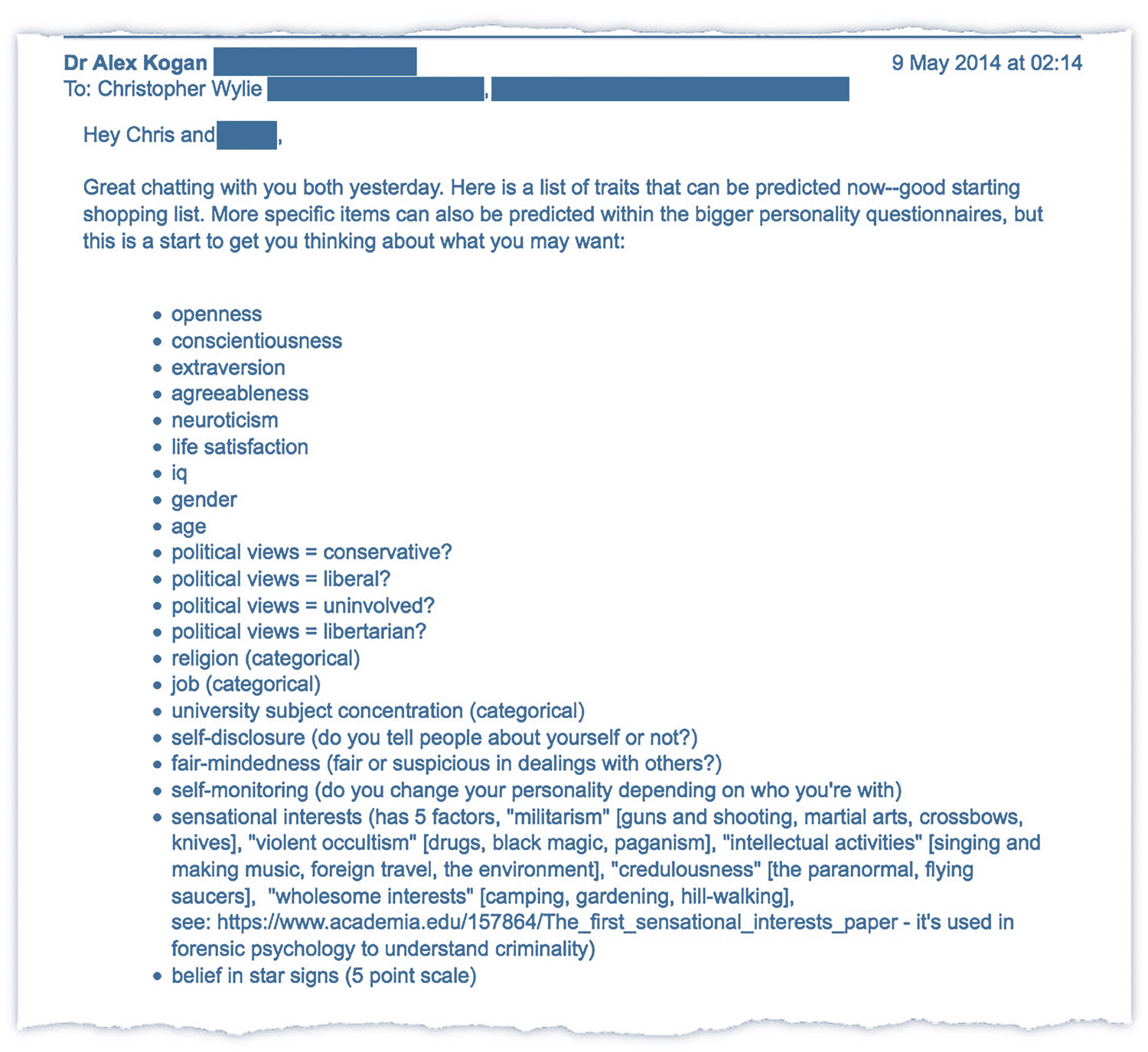

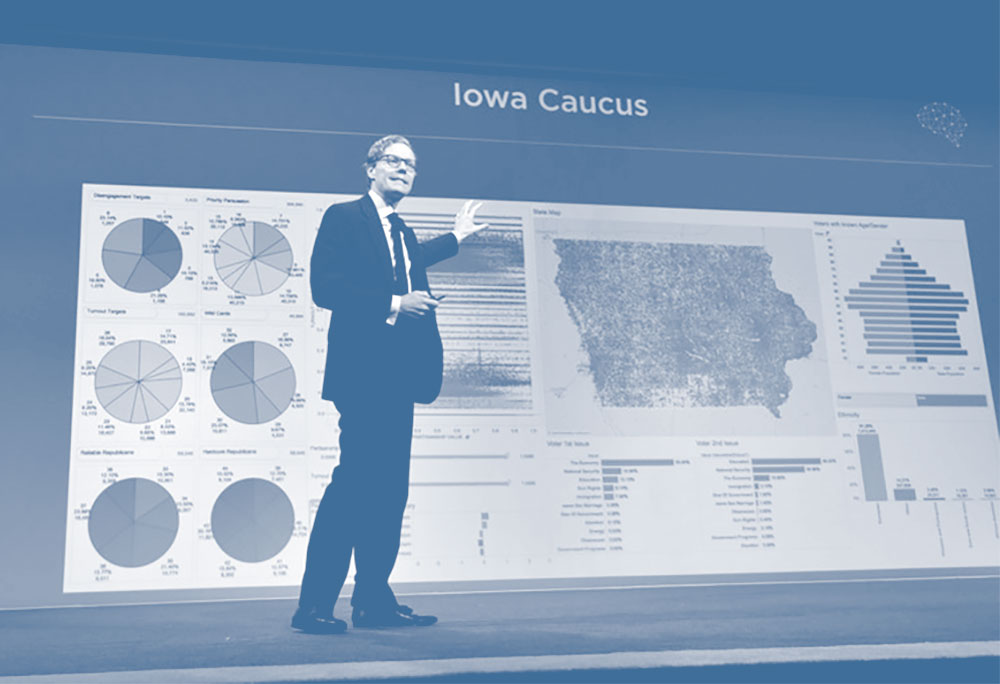

Si nous souhaitons garantir la responsabilité des médias sociaux en terme d’utilisation de nos données personnelles et de diffusion de contenus idéologiques, nous devons définir clairement les termes du “ contrat moral ” que nous passons avec ces derniers, pour cesser d’entretenir le flou économico-idéologique ayant mené à l’affaire Cambridge Analytica. Comme je l’ai évoqué dans la première partie de cet article, le rôle de l’État dans cette régulation est fondamental, mais loin d’être suffisant. L’État français a cependant récemment pris conscience de l’importance de ces sujets et commencé à légiférer dans ce sens, en votant le 22 décembre 2018 la “

loi relative à la lutte contre la manipulation de l'information ”. Celle-ci s’applique aux “ opérateurs de plateforme en ligne [...] dont l'activité dépasse un seuil déterminé de nombre de connexions ” et leur impose un certains nombres d’impératifs et de règles dans les trois mois précédant une élection “ au regard de l'intérêt général attaché à l'information éclairée des citoyens en période électorale et à la sincérité du scrutin ”. Facebook et les autres médias sociaux sont donc notamment tenus de “ fournir à l'utilisateur une information loyale, claire et transparente ” sur l'identité des annonceurs qui “ versent à la plateforme des rémunérations en contrepartie de la promotion de contenus d'information se rattachant à un débat d'intérêt général ”, mais aussi de “ rendre public le montant des rémunérations reçues en contrepartie de la promotion de tels contenus d'information lorsque leur montant est supérieur à un seuil déterminé ” sous la forme d’un registre électronique ouvert mis à la disposition des utilisateurs. La loi se veut aussi plus répressive, permettant au juge des référés (juge administratif permettant d'obtenir en urgence des mesures provisoires et rapides) de prendre “ toutes mesures proportionnées et nécessaires ” pour faire cesser la diffusion sur les médias de toutes “ allégations ou imputations inexactes ou trompeuses d'un fait de nature à altérer la sincérité du scrutin à venir [...] diffusées de manière délibérée, artificielle ou automatisée et massive ”. Enfin, la loi stipule que les plateformes s’engagent à lutter contre la diffusion de telles informations, en mettant en place “ un dispositif facilement accessible et visible permettant à leurs utilisateurs de signaler de telles informations ”, mais aussi des mesures complémentaires concernant “ la transparence de leurs algorithmes ” ou “ la lutte contre les comptes propageant massivement de fausses informations ”, bien que le texte reste assez peu précis concernant ces derniers points.

De nombreux députés ont critiqué cette loi, approuvée à seulement 347 voix contre 204, la jugeant inutile, inefficace et menaçante pour la liberté d'expression. Cette posture peut sembler naïve au regard du besoin urgent de transparence quant aux actions de ces plateformes, et le manque de spécificité du texte témoigne de la difficulté pour nos représentants politiques de s’emparer d’enjeux technologiques dont ils peinent souvent à comprendre les fondamentaux. S’il me semble pertinent de contraindre Facebook de manière préventive avant que ne se produise une affaire similaire à Cambridge Analytica en France, les modalités d’application de cette loi paraissent encore très incertaine, une question aussi soulevée à plusieurs reprises dans les débats politiques.

Interrogée à ce sujet pour RT France, Nathalie Mallet-Poujol, chercheur au CNRS en sociologie et sciences du droit et ancien avocat au barreau de Paris, se disait “ sceptique sur la faisabilité de cette mesure de référé spécifique ”. Face à l'urgence de la procédure prévue par la loi, elle s’interrogeait sur la possibilité de “ juger sous 48 heures de la véracité d'une information ” dans la mesure où “ il faut être certain de la fausseté de l'information ”. Elle rappelait en effet que “ le concept de manipulation de l'information est plus difficile à saisir que celui de la fausseté : c'est à la fois juridique et politique ”, rejoignant ce qu'expliquait Nathaniel Gleicher (dans l’

article du Monde évoqué plus haut) au sujet de la complexité de la lutte contre les tentatives de manipulation ou de corruption chez Facebook dans le cadre des élections européennes. Le flou qui demeure dans le texte et dans son application reflète donc bien la difficulté de poser des régulations précises aux pratiques d’Astroturfing : celles-ci reposent sur la dissimulation de l’origine réelle des messages diffusés, facilitée par la structuration en réseaux de plus en plus tentaculaire des médias sociaux, et rendent donc de plus en plus complexe de surveiller l’ensemble du système et de remonter rapidement à la source des informations. L’avenir nous dira quels moyens les États seront prêt à mettre en place pour mener ce travail, et quel pouvoir de restriction ils pourront et voudront exercer réellement sur ces médias...

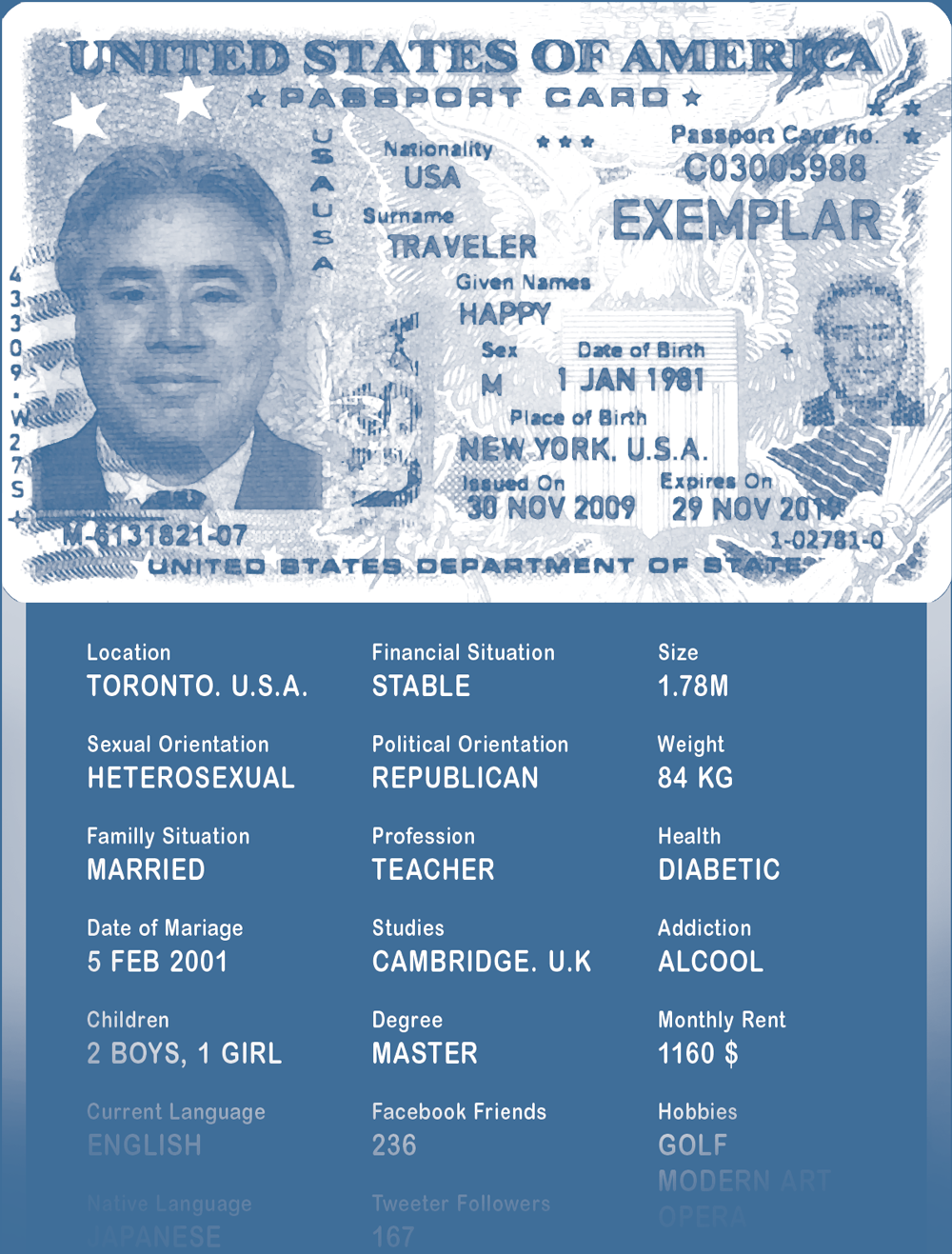

Je crois que nous ne pouvons cependant pas nous reposer seulement sur la loi pour définir notre rapport aux médias sociaux que nous utilisons. Comme l’expliquait Fabrice Epelboin avec l’exemple de Facebook en Tunisie, “ les médias sociaux nourrissent une grande possibilité de libération pour les populations ”, en leur permettant de faire communauté, de débattre, et de se fédérer pour porter des messages avec une ampleur qui serait difficile à atteindre autrement. Pour que cette utilisation reste contrôlée, il me semble donc primordial que nous prenions l’habitude de questionner les médias sociaux que nous utilisons et de modérer l'usage que nous en faisons. Ce "contrat social" que nous établissons tacitement avec ces systèmes doit répondre à divers enjeux, les principaux étant l’utilisation faite de nos données et la transparence du système quant à l’origine et la visée des annonces et des contenus auxquels il nous expose. Pour cela, nous devons apprendre à démêler la complexité des acteurs “ en amont ” de ces systèmes, fournisseurs de technologies et de contenus qui ne sont plus clairement identifiables ni responsables, mais aussi celle de l'aval, groupes multiples d’usagers interdépendants qui s’influencent mutuellement entre eux en interagissant. S’il peut être compréhensible que nous concédions à ces systèmes une partie de notre vie privée sous formes de données personnelles en échange d’usages utiles et confortables, c’est cette relation entre amont et aval qui doit être définie et mise en débat.

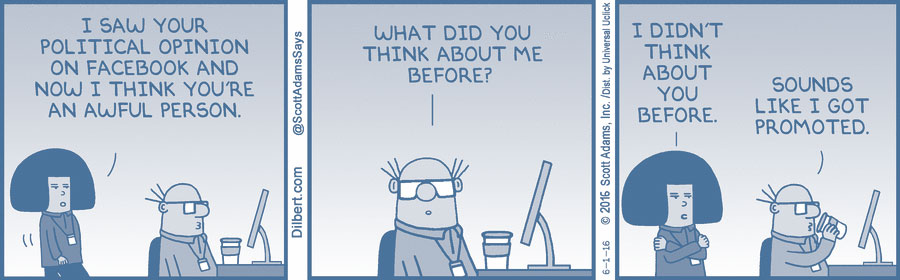

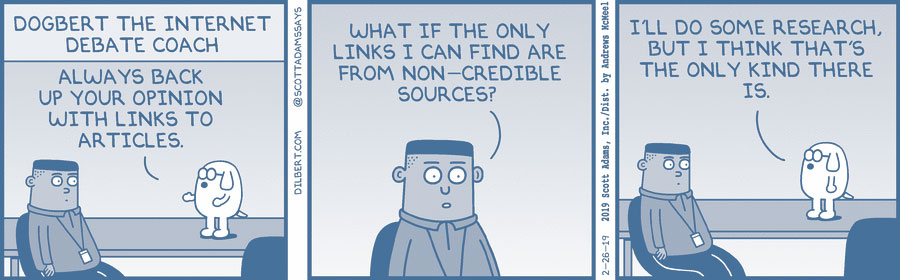

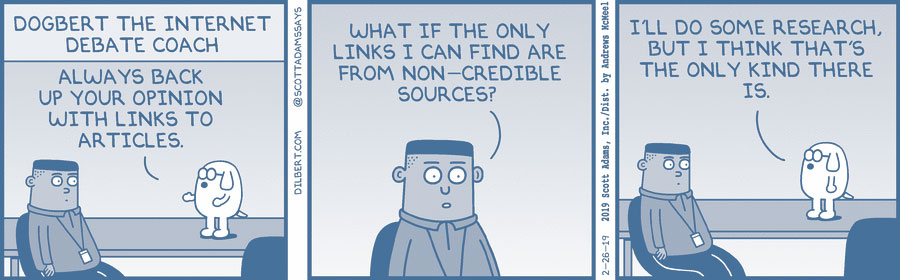

Dilbert, Scott Adams, 2019

Dans la mesure où nous consentons à fournir nos données personnelles à des fins commerciales aux grands médias sociaux, nous sommes légitimement en droit d’exiger en retour de savoir ce qu’ils en font, et de faire pression sur eux collectivement via l’utilisation que nous faisons de leurs services, sachant que c’est de cette utilisation que dépend leurs profits. Après l’affaire Cambridge Analytica, Facebook a bien compris la crise de la confiance qu’il a fait subir à ses utilisateurs, alors qu’une

étude du Pew Research Center, centre de recherche statistique américain, a évalué que 26% des Américains ont décidé de supprimer l'application du réseau social de leur mobile quelques mois après le scandale, proportion atteignant même 44% chez les jeunes utilisateurs. Cette pression sociale, s’ajoutant aux comptes que le média a dû rendre à la justice américaine, a eu des conséquences : l’entreprise a par exemple annoncé travailler au chiffrement des conversations de ses utilisateurs, ce qui empêcherait Facebook de pouvoir lire ce que nous y écrivons, même si le système pourrait encore récupérer nos données contextuelles. Face aux scandales de manipulation de l’opinion dans certains pays, Mark Zuckerberg a aussi annoncé que Facebook n’implanterait plus de serveurs dans des pays dotés de “ mauvais bilans en matière de vie privée et de liberté d’expression ”, quitte à renoncer à certains marchés, comme la Chine. Joël de Rosnay, actuel président de la cité des sciences et du palais de la découverte, prédisait déjà en 2007 l’importance de ce “ feedback citoyen ” dans son livre “ 2020 : Les Scénarios du futur ”. Il y abordait notamment le développement des médias de masse, analysant que leur essor “ nous laisse entrevoir une opportunité d’équilibrer la société plus efficacement, en trouvant un compromis entre la régulation par le haut et la corégulation par le bas ”. Cette vision qu’il appliquait alors au champ politique, pour lequel la structuration des citoyens constitue un “ contre-pouvoir fondé sur l’intelligence connective et les médias des masses ”, s’applique donc aujourd’hui aux médias de masse en eux-même, qui dépendent économiquement de leurs utilisateurs et peuvent donc être impactés par l’utilisation que ces derniers font de leur système.

Afin de rendre impactante cette pression que nous pouvons mettre en tant qu’utilisateurs sur ces grands médias, nous devons donc nous éduquer à décortiquer et analyser leurs logiques de fonctionnement, pour discerner leurs intérêts comparativement aux nôtres. L’éducation populaire à ces sujets pourrait je crois constituer un sujet sociétal de grande importance dans les années à venir, auquel notre système éducatif devra en particulier s’atteler. De la même façon que certaines écoles et universités proposent déjà des cours d’éducation aux médias, il devient urgent de proposer aussi une éducation aux médias sociaux, afin d’accompagner les utilisateurs inexpérimentés dans l’usage qu’ils en font. Un lieu commun voudrait que la jeune génération ayant grandi avec ces systèmes en maîtrise parfaitement les codes, ce qui est je crois totalement faux. Ayant eu l’occasion de discuter de ce sujet avec plusieurs professeurs de lycée, ils m’ont expliqué que si leurs élèves maîtrisent en effet les usages de ces plateformes, ils sont loin d’en comprendre les principes de fonctionnement, les modèles derrières les interfaces simplifiées. Pourtant une

étude de la CNIL datant de 2017 montre que les enfants se mettent aujourd'hui à naviguer sur ces réseaux de plus en plus jeunes, sachant que 57% des élèves du collège sont connectés à Facebook, 18% des moins de 13 ans y ayant même leur propre compte, enfreignant l’âge minimal d’utilisation autorisé par le média. Dans le même temps, l’étude montrait que ces jeunes utilisateurs sont loin d’être éduqués aux pratiques de ces réseaux, seuls 55% de ces jeunes utilisateurs discutant avec leurs parents de l’utilisation qu’ils en font et 50% d’entre eux s’y connectant seuls depuis leur ordinateur personnel. Alors que l’éducation que les plus jeunes utilisateurs reçoivent ne va pas de pair avec l’âge auquel ils sont exposés à ces systèmes, il est primordial de changer d'approche et de développer très tôt ce recul critique chez ces jeunes générations. Comme l’évoquait dans une

conférence Joël de Rosnay au sujet des nouvelles technologies et des informations qu’elles véhiculent, il est primordial pour la jeune génération de les “ re-contextualiser [...] dans un contexte social, économique, politique, technologique ”. Il prônait pour cela une co-éducation trans-générationnelles : les plus âgés qui ont vu naître ces technologies aidant les plus jeunes à comprendre leurs origines (à condition d’y avoir été éduqué donc)… et se faisant en retour aider par les plus jeunes dans la maîtrise des nouveaux usages de ces systèmes ! Cette recontextualisation me semble en effet essentielle à la définition du contrat moral passé entre fournisseurs et usagers de ces technologies, permettant de rééquilibrer ce que l’utilisateur sait du fonctionnement du système relativement à ce que ce dernier sait de ses utilisateurs.

Les commentaires autour de l’affaire Cambridge Analytica et de ses équivalents internationaux ont énormément parlé de manipulation de l’opinion, comme j’ai parfois pu le faire dans cet article, véhiculant l’idée que les utilisateurs en ayant été victimes n’ont rien pu faire. S’il est vrai que de telles manipulations ont lieu à nos dépens, je crois que nous ne pouvons cependant pas rester inactifs face à elles. Au delà d'exiger d’éventuelles actions de régulation de ces plateformes par les États, nous devons reconnaître notre responsabilité individuelle face à ces nouveaux usages des médias sociaux : celle de développer notre compréhension et notre esprit critique, afin de faire preuve de discernement lorsque nous naviguons sur ces plateformes. Car si la manipulation a une limite fondamentale, c’est celle de notre refus à nous faire manipuler. La connaissance des logiques de fonctionnement des médias sociaux est donc une première étape pour être conscient de cette potentielle manipulation et nous en méfier. Nous pouvons ensuite approfondir ce travail par la restriction des données personnelles que nous livrons à ces systèmes. Enfin, le “ fact checking ”, vérification systématique des contenus auquel nous sommes exposés et que nous diffusons sur ces médias constitue un autre niveau d’implication primordial. Le contrat fournisseur/utilisateur ne peut pas être unilatéral, il doit aussi nécessiter un engagement fort des usagers : face à l’ampleur que prennent aujourd’hui les médias sociaux et leur rôle dans nos sociétés, nous devons devenir moins passifs et faire preuve de plus de recul critique dans l’utilisation que nous en faisons.

Fake News affirmant que le pape François soutient Donald Trump pour l'élection présidentielle de 2016, anonyme, 2016