Comment programmer et réguler l’inévitable développement des IA dans le futur ?

Au vu de l’enjeu économique que représente l’IA et des investissements massifs de la France dans le domaine, son développement exponentiel dans les années à venir semble être une évidence. Pourtant au fur et à mesure que ces technologies se perfectionnent, leur rôle pourrait devenir de plus en plus controversable... Que ce soit dans le domaine du travail, de la santé, des transports, de l’économie ou bien d’autres, lorsque ces IA seront capables techniquement d'être de plus en plus prédictives et injonctives, quelles utilisations serons nous prêt à en faire ? L’éthique et la gouvernance de ces systèmes technologiques seront un enjeu majeur des décennies à venir. Mais alors, comment organiser cette régulation et par qui doit-elle être menée ?

Une première piste souvent citée concerne la capacité des entreprises développant des IA à s’auto-réguler. Sundai Pichai, actuel PDG de Google, expliquait dans une

interview donnée fin 2018 au Washington Post que les craintes au sujet de l’intelligence artificielles sont “ très légitimes ”, mais que l’on pourrait “ faire confiance à l’industrie technologique pour réguler son usage de manière responsable* ”. Il fait notamment le parallèle entre ces questions relatives au développement des IA et celles qui se sont posées lors du développement de la recherche en génétique, soulignant à juste titre que de nombreux biologistes ont su poser des limites à leurs recherches et “ qu’il y a eu beaucoup d'autorégulation de la part du milieu universitaire ”. Pichai a aussi récemment révélé une

charte des principes éthiques relatifs au développement de l’IA chez Google, qui touche aussi bien la programmation, le développement et la mise en place de ces technologies. Ses grands principes concernent l’impact social des IA (en particulier en termes de discrimination), ses domaines d’applications prohibés (comme l’armement ou les outils de surveillance) ou encore la protection des données personnelles des utilisateurs. Google a par ailleurs également co-signé avec 247 entreprises et 3253 acteurs du domaine un “

pacte pour les armes létales autonomes ”, tous les signataires s'engageant à ne pas participer de quelque façon que ce soit au développement des ces “ robots tueurs ”, systèmes d’IA capables d’identifier une cible humaine et de l’attaquer de manière autonome. Ce pacte est à l’origine du très médiatisé “

Future of Life Institute ”, association transnationale de contributeurs volontaires qui étudie les risques existentiels menaçant l’humanité et en particulier ceux liés à l’IA, en rassemblant différentes personnalités influentes du monde de la recherche publiques ou privées comme le cosmologiste Stephen Hawking (avant sa mort en 2018), le cofondateur de Skype Jaan Tallinn, l'informaticien spécialisé dans l’IA Stuart Russell ou encore l'entrepreneur et PDG de Tesla Elon Musk.

Sommaire des objectifs pour les applications de l'IA, Google, 2018

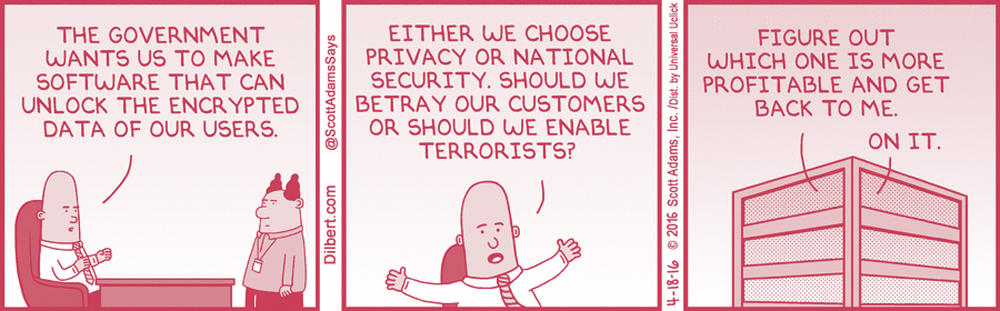

Pourtant, si l’intention de ce type d’engagements peut paraître louable, il semble impossible de laisser les entreprise seules responsables de la régulation éthique des projets qu’elles développent. Avant de mettre en place sa charte, Google a par exemple été vivement critiqué en interne après avoir signé un contrat avec le département de la défense américain impliquant le développement d’une IA destinée à être utilisée dans des drones militaires, capables de reconnaître et “ d’étiqueter ” automatiquement des voitures, des bâtiments et d'autres objets. Si ce contrat a depuis été abandonné, cette affaire met en évidence l’ambivalence des entreprises qui disent avoir de réelles préoccupations éthiques, tout en étant fortement guidées par des intérêts stratégiques et commerciaux pouvant entrer en conflit avec ces préoccupations. Il paraît évident que l’appréciation du bien fondé d’un projet d’IA est soumise à une grande marge d’interprétation… Car au delà des cas extrêmes comme celui des robots tueurs, comment réguler les systèmes portant atteinte de manière plus insidieuse aux libertés individuelles ?

Dilbert, Scott Adams, 2016

Interviewée dans le cadre d’un

épisode de la chaine Youtube Datagueule dédié à cette question de la programmation des algorithmes, la journaliste et webdesigner Soline Ledesert rappelait que le développement de ces derniers sert avant tout les intérêts privés des entreprises qui le financent, qui “ n’ont pas, par leur statut même, à tenir compte d'intérêts publics, mais ne le font que s’il y a une pression des gouvernements ou des citoyens ”. Soline Ledesert a notamment participé à l’intéressant projet d’un “

serment d’hippocrate des data scientist ”, une charte éthique commune qu’acceptent de suivre les concepteurs d'algorithmes et d’IA signataires. Pourtant, même en faisant preuve d’éthique et de bonne volonté, leur action restera inévitablement restreinte si elle s’oppose aux orientations stratégiques de leurs entreprises...

Cette régulation du développement des IA doit donc selon moi impérativement se faire de manière restrictive pour les entreprises. Si l’Etat semble être l’entité la plus à même d’imposer une telle restriction, l’évolution de la législation passée a montré son inertie et sa difficulté à suivre et réguler les évolutions très rapides des nouvelles technologies. Dominique Boullier, sociologue spécialisé dans les évolutions technologiques, évoque sur sa

chaîne Youtube ces enjeux de régulation, expliquant que “ nous sommes habitués au fait que les décisions techniques sont toujours prises par les ingénieurs et les firmes et pas par les gouvernements ni les citoyens ”, faute de compétences techniques de ces derniers. Ce sont donc souvent les entreprises qui discutent directement entre elles, dans une sorte de flou démocratique dans lequel “ les questions de sécurité sont sous-estimées ” pour ne pas “ entraver l’innovation et la fluidité du commerce ”. Face à cette “ étonnante débandade du politique face à la toute puissance des ingénieurs et des firmes, que nous risquons de payer très cher ”, il rappelle l’importance de fonder des “ politiques des systèmes numériques ”. Des initiatives ont depuis eu lieu pour aider les députés et membres du gouvernement à saisir les enjeux technologiques sur lesquels ils sont amenés à légiférer. La plus probante est sans doute le rapport ministériel “ Donner un sens à l’intelligence artificielle : pour une stratégie nationale et européenne ” mené sous la direction de Cédric Villani, mathématicien français lauréat de la médaille Fields, aujourd’hui devenu député de la majorité et président de l’office parlementaire d'évaluation des choix scientifiques et technologiques (OPECST). Ce rapport aborde les questions de la protection et de l’ouverture des données, des enjeux économiques qui y sont associés, des impacts de tels systèmes sur l’emploi, la santé ou encore l’agriculture… Des profils comme celui de Cédric Villani, personnage influent du champ de la recherche scientifique, me semblent être une intéressante façon de permettre l’appropriation par le champ politique de ces questions. Dans une

interview pour la chaîne Youtube Thinkerview, il estimait d’ailleurs avoir été élu car “ les citoyens se disaient “ c’est bien d’avoir des scientifiques qui vont en politique et qui vont apporter leur expertise là-bas, et qui permettront aux politiques de juger et délibérer en connaissance de cause ” ”. Il rappelait alors à juste titre que “ l’IA c’est ce qu’on en fera, [...] il faut que le politique prenne ses responsabilités, il faut qu’on évite à tout prix la prolifération de ces technologies, et qu’on ait des accords mondiaux sur ces questions ”.

Pourtant, cette capacité du corps politique à légiférer pour la régulation de ces systèmes technologiques dans l'intérêt public est aussi contestable, celui-ci étant soumis comme les entreprises à de nombreux conflits d'intérêt. Dans l’interview évoquée plus haut, le philosophe Éric Sadin affirmait de manière assez radicale que les élus sont aujourd’hui “ totalement inféodés aux intérêts économiques des entreprises ”. De fait, dans un modèle capitaliste comme le nôtre, un grand risque est que les lois relatives à ces questions technologiques soient avant tout votées en vue de favoriser la croissance et d’assurer l’avenir économique du pays. Comme dans de nombreux autres domaines, Sadin affirme qu’il y a un fort lobbying des grands groupes des technologies numériques pour que leurs développements futurs soient “ supportés par des lois et des investissements publics ”. L’Etat seul ne suffira donc probablement pas non plus à réguler de manière restrictive les usages émergents des systèmes d’IA…

D’autres groupes ou personnalités indépendantes pourraient alors jouer ce rôle de garde-fou dans ces développements futurs. La Commission nationale de l'informatique et des libertés (CNIL), une organisation gouvernementale qui informe, aide et contrôle les entreprises au sujet de la protection des données personnelles des citoyens en ligne, a par exemple mené un

débat public sur les enjeux éthiques des algorithmes et de l’intelligence artificielle, présenté au gouvernement sous la forme d’un

rapport de synthèse fin 2017. Elle y dégage deux principes régulateurs pour l’intelligence artificielle : un principe de loyauté, impliquant que tout algorithme doit faire primer avant tout les intérêts de ses utilisateurs, et un principe de vigilance, prônant un questionnement régulier, méthodique et délibératif dans le développement des algorithmes. Ces principes pourraient selon la CNIL devenir “ une nouvelle génération de garanties et de droits fondamentaux ”, appliqués aux développements futurs de l’IA. Plus concrètement, la CNIL pourrait alors forcer les entreprises développant des IA à respecter les libertés individuelles de leurs utilisateurs et sanctionner les développements jugés “ non-éthiques ”, de la même façon qu’elle a été chargée en 2018 par l’Etat de l’application du

Règlement Général sur la Protection des Données (RGPD) en France et du contrôle des entreprises. Pourtant, ce contrôle pourrait être difficile à exercer dans les faits : interrogée par Reuters, l’

American Civil Liberties Union (ACLU), association à but non lucratif américaine ayant pour mission de “ défendre et préserver les droits et libertés individuelles garanties à chaque citoyen par la Constitution et les lois des États-Unis ”, estimait au sujet des IA utilisées dans le recrutement qu’il pourrait être extrêmement difficile dans le futur de poursuivre un employeur en justice pour des embauches automatisées, les candidats pouvant difficilement prouver que le système a été utilisé...

Affiche d'appel à volontaires de la CNIL, Kiki et communication interne, 2017

Enfin les penseurs, philosophes et essayistes pourraient eux aussi jouer un rôle important dans la définition du futur de ces systèmes, qui nous amèneront peut être à terme à redéfinir en profondeur notre rapport au travail, à la santé, à la connaissance… L’essayiste Laurent Alexandre racontait dans l’interview citée plus haut ce qu’il a pu observer quand il a commencé à s’intéresser à ces questions, en rencontrant des informaticiens, mathématiciens et data scientist : “ Je n’ai vu personne qui réfléchissait aux conséquences politiques, sociales et éducatives de l’IA. J’ai vu des gens le nez dans le guidon qui réflechissaient à leur algorithme, incapables de voir ce que le tsunami de l’IA allait faire à un an, cinq ans, dix ans, cinquante ans, mille ans, un million d’années. Aucune réflexion, parce que les acteurs de l’IA n’ont pas de pensée politique, ils n’ont pas de pensée sociale, ils n’ont pas de pensée économique. ” Ce manque de recul critique chez les acteurs du développement technologique est une idée commune, et l’ampleur des enjeux que ce dernier soulève justifie sans doute pourquoi il est essentiel que des penseurs, autonomes par rapport aux intérêts financiers des technologies en question, aient du temps et des moyens à consacrer à l’étude de leurs répercussions.

Mais un acteur manque encore à la table de réflexion et de législation autour de ces questions : vous ! Qu’en est-il en effet de notre rôle à tous, citoyens et futurs usagers majoritaires de ces systèmes technologiques en développement ?